ついに、マシンガンを装備した「犬型ロボット」が登場してしまいました。ただしこれは、跳んだり走ったり蹴っても立ち上がるロボットで知られるボストンダイナミクス(Boston Dynamics)によるものではありません(というのも、同社は自社のロボットに武装させることはないと明言しています)。今月開催された米陸軍協会の武器展示会で公開されたのは、ゴーストロボティクス(Ghost Robotics)とソードディフェンス(Sword Defense)が製作したものでした。

ゴーストロボティクスは、まだあまり知られていない会社ですが、「無人兵器システムの未来、その未来はいま」(future of unmanned weapon systems, and that future is now)というスローガンを掲げています。

軍にとって自律型兵器は「戦争の次の進化形」ですが、米国の技術者の中には、人工知能(AI)を殺人や監視活動に用いる可能性のある組織で働くことに否定的な人もいます。彼らの多くは、ドローンによる爆撃で罪のない一般市民が犠牲になっていたり、米国をはじめとする国々が人権を尊重しているとは思えない方法で監視権限を行使していることをすでに見聞きしています。また、深い考えなしに原子兵器の時代を切り開いた科学者の後悔も見てきました。

しかし明らかに、米国のテック業界はいまも軍のために多くの仕事をしていて、その状況もすぐに変わらないでしょう。ボストンダイナミクスがそうせずとも、別の、ゴーストロボティクスがAIを「武装」させるのです。

今年3月にも、グーグル元CEOのエリック・シュミット(Eric Schmidt)やアマゾンの現CEOアンディ・ジョリー(Andy Jolly)らが名を連ねる国家安全保障委員会は、AI分野における米国の優位性が危機に晒されていると報告しています。ロシアや中国に後れを取らないよう、米国が戦場に可能な限りの技術を投じないとはいえません。

では、進むべき道はひとつでしょうか? まずもって、ロボット兵器に明確な線引きをする原則を採用することが、人類にとってもシリコンバレーにとっても、最も賢明な道となるはずです。

A BRIEF HISTORY

戦争とテック

1675年:ストラスブール協定で毒の入った銃弾の使用が制限される。これは、最初の軍備管理に関する条約の一つとされる。

1958年:シリコンバレーの草分け的企業である半導体メーカー、フェアチャイルドセミコンダクター(Fairchild Semiconductor)が、核弾頭を搭載した戦略兵器「ミニットマン」用チップの製造を受注。米国政府からの早期からの投資を背景に、近代的なトランジスタの需要が高まった

1968年:米・英・旧ソ連など56カ国が核兵器不拡散条約に調印

1969年: 米国防総省の高等研究計画局(ARPA、現在のDARPA)が資金提供したネットワーク実験「Arpanet」に接続された2台のコンピュータ間で、後にインターネットとなる最初のメッセージが送信される

1983年:国防高等研究計画局(DARPA)の資金援助を受け、イスラエルのエンジニア、エイブラハム・カーマン(Abraham Kerman)が、自宅のガレージで、将来の米国のドローンの基礎となる自動操縦の無人航空機を製作

2003年:テロ対策を目的としたデータ分析会社パランティア(Palantir)が設立

2015年:先進的な技術をより早く軍の手に届けるために、国防イノベーションユニット(DIU)が設立される

2017年:中国が「AIで世界のリーダーになる」ことを目した1,500億ドル(約17.1兆円)の計画を発表

2018年:グーグルが、米国防総省のAI活用パイロットプログラム「プロジェクト・メイヴン」(Project Maven)との連携を、従業員の反対により終了

TERM OF ART: “DUAL USE”

デュアルユースを危惧

技術者がAIについて危惧するポイントは? まず、AIは「デュアルユース」(政治、外交、輸出管理において、平和および軍事、両方の目的に使用できるテクノロジー)であり、新薬の研究、自動車の運転、ビデオゲームなどの民生用途と、犯罪者の発見、武器プラットフォームの操作、テロリストの追跡などのセキュリティ用途があります。また、民間企業は防衛関連企業よりも早く資金を調達して新技術を市場に投入することができるため、最高のAI技術は、グーグルのような表向き「消費者向け」の企業にあるといえます。

ミャンマーの少数民族ロヒンギャが迫害されている問題に関連してFacebook上でヘイトが拡散していたように、テクノロジーの「意図しない結果」は容易に散見されます。2018年にグーグルで起こった「プロジェクト・メイヴン」騒動では、一部のコンピュータ科学者が、自律型ドローンが収集した映像に適用する認識ツールの開発に抵抗しました。 米国防総省は、この技術は人間の分析官がテロリストを探す時間を短縮するために使われるとしていますが、技術者たちは、人間が監視していなくても致死的な力を行使することができるのではないかと懸念していたのです。今年、空軍はこの技術を使って爆撃目標を選定するデモストレーションを行う予定です。

一方で、テック企業の批評家は異なる見方をしています。それは、グーグルをはじめとする大手企業は、中国の国内市場でのビジネスチャンスを逃したくないため、米軍との関係を疑われたくないと考えている、ということです。

THE MILITARY-TECHNICAL COMPLEX

政府との切れない関係

グーグルが「プロジェクト・メイヴン」から手を引くことを決めたにもかかわらず、シリコンバレー全体では、米国の国家安全保障に関わる仕事を多く行っており、多くの場合、下請け業者を介して行われています。

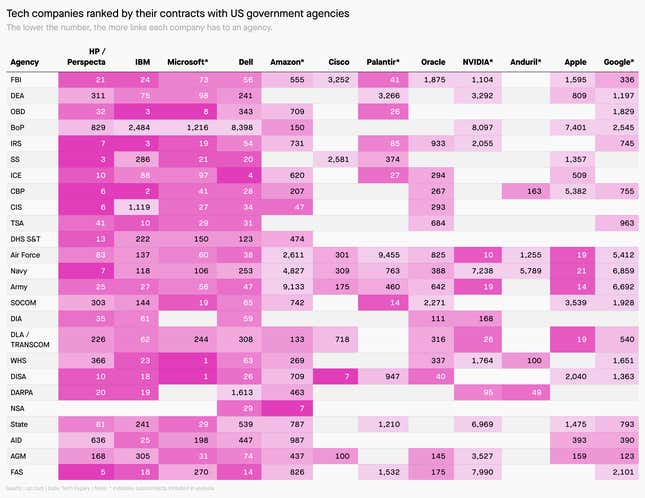

グーグルのコンピュータ科学者であり、AIの研究を理由に辞職したジャック・ポールソン(Jack Poulson)は、政府の記録を調査し、テック企業と国家安全保障機関の深いつながりを明らかにしました。下記チャートは、米国政府機関との契約数が多いテック企業を色別にランク分けしたものです。

WHO WILL WATCH THE ROBOTS?

曖昧なルールの存在

パランティアやアンデュリル(Anduril)、さらにはゴーストロボティクスのような企業の台頭は、米国を守るという課題に意欲的に取り組む企業が存在することを意味しています。しかし、米国国防総省の関係者は、軍や諜報機関が倫理的に運用するとは信じていないために、最も優秀なエンジニアや科学者をAIプロジェクトに起用する機会を逃しているのではないかと懸念しています。

また、軍拡競争の問題もあります。高度な兵器の開発は、より強力な兵器を作るという自己を正当化する状況に陥りやすく、資源の配分ミスや経済問題を引き起こす可能性があります。焦ってセキュリティ業務にAIを導入すると、バイアスによる間違いやデータの不備、あるいは単なるバグによるミスの可能性が高まります。

AI兵器の使用を制限したり、その使用に関する健全な原則を打ち出す世界的な合意が、役に立つのでしょうか? 技術者や哲学者たちは、10年以上前からそのようなルールを求めてきました。自律兵器(軍事用ロボット)については国際法が曖昧であり、米国のドローン戦のように半自律的な応用であってもグレーゾーンに存在しています。地雷やレーザー兵器の使用を制限する国際協定である「特定通常兵器使用禁止制限条約」では、AIをどのように規制するかが議論されていますが、進捗は遅々として進んでいません。

また、ここには、一つの争点があります。それは、自律兵器に関する潜在的な制約に同意した人たちが、それを守るかどうかを確かめるということです。AI開発は、核兵器や大陸間弾道ミサイルよりも追跡が難しく、また、核不拡散を妨げようとする試みが現にあるように、現地査察がすべての人を納得させるわけでもありません。

BY THE DIGITS

数字でみる

1万3,000人:2014〜19年の間にイラクで米国のドローン攻撃により死亡した民間人の推定人数

0.1%:質の高い顔写真を用いた、代表的な顔認識アルゴリズムのエラー率(研究環境において)

9.3%:上記と同じ(上記の)アルゴリズムで「自然界」の画像を使用した場合のエラー率。

20%:今後4年間に米国が自律型ドローンを使用して人間を殺害する可能性(ジョージタウン大学のシンクタンクCenter for Security and Emerging Technologyの予測による)

50%:サイバー空間安全保障・新興技術局(CSET)が予測した、米国のビッグテック5社に対する連邦政府との契約金の増加率

PREDICTION🔮

今後の予想

過去の軍拡競争から学ぶべきことがあるとすれば、それは「抑制の努力」よりも「深刻な結果」が先行するということです。国際機関はAIとその応用の定義に悩み、多くの政府が、海外からの脅威に対して偏執的になっています。

これまでの人類の歴史を見てきても、軍事についてはあらゆることが後手に回ることが多いのが事実です。AIに関しても、何か重大な事故が起こったり、敵との衝突寸前の状態にならないと、AIの適切な位置づけは決まりません。そのため、分別ある市民やNGOは、社会運動などを通して健全な政策を推進し、備えるほかないのです。

ONE 🧨 THING

最後に…

世界最初の「自動化された兵器」といえば。それは間違いなく、人や車両の接近によって爆発する「地雷」でしょう。これらの兵器は、紛争が終わった後も放置されたままで、主な犠牲者となっている一般市民に恐ろしい脅威を与えています。世界のほとんどの国がこういった兵器を禁止していますが、米国はドナルド・トランプ元大統領のもとで対人地雷の使用規制を緩和しました。

今日のニュースレターは、シニアレポーターのTim Fernholzがお届けしました。日本版の翻訳は福津くるみ、編集は年吉聡太が担当しています。みなさま、よい週末をお過ごしください!

🎧 Podcastでは「お悩み相談 グローバルだけど」の最新話を公開中。お悩み・お便りはこちらから。Apple|Spotify

👀 Twitter、Facebookでも最新ニュースをお届け。

👇 のボタンから、このニュースレターをTwitter、Facebookでシェアできます。ニュースレターの転送もご自由に(転送された方へ! 登録はこちらからどうぞ)。